Tout a commencé par une question simple : pourquoi 230V ?

Je ne pouvais par la même occasion m’empêcher de me demander : pourquoi est-ce le double que les Etats-Unis ? Pourquoi les tensions électriques domestiques diffèrent-elles suivant les zones géographiques ?

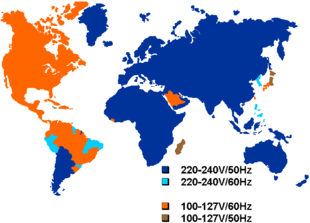

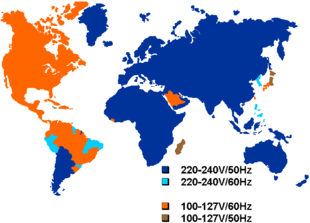

Tensions électriques domestiques dans le monde

Chronologiquement, il fallait d’abord se pencher sur le cas des Etats-Unis et a fortiori de l’Amérique du Nord pour trouver quelle fut la première tension électrique domestique choisie, et pourquoi.

« The penalty of leadership »

Les pionniers ont le privilège du choix, mais aussi l’impossibilité de se baser sur l’expérience pour le rendre optimal. Il semblerait que les Etats-Unis en aient ici fait les frais. L’histoire montrera que cette formidable capacité à innover ne les a pas toujours desservis : les récentes avancées dans le domaine des voitures électrique (avec Tesla Motors), les bases du réseau Internet qui permettra l’avènement de sites comme Google ou Comparavel, sont là pour en témoigner.

L’électricité était tout d’abord destinée à l’éclairage, via les ampoules mises au point par Thomas Edison (alias sa société General Electric), ainsi qu’aux moteurs. C’est ce même Edison qui déploya les premiers réseaux de courants continu (DC) suite à l’obtention d’un brevet en 1882. Ceux-ci avaient pour particularité d’être constitués de générateurs alimentant un réseau de distribution formé d’épais câbles conducteurs, et jamais distants de plus de 1 ou 2 kilomètres des clients. L’ensemble du réseau fonctionnait avec la même tension que celle appliquée aux bornes des appareils électriques finaux. Une lampe de 100V était ainsi reliée à un générateur de 110V, les 10V supplémentaires étant généralement perdus durant le transport. Le voltage (anglicisme pour tension électrique) était donc choisi en fonction des besoins des appareils connectés, en l’occurrence principalement les lampes. Celles-ci avaient été spécialement conçues pour que les filaments de carbone supportent une centaine de volts, afin de fournir un éclairage performant mais surtout compétitif face aux traditionnelles ampoules à gaz. 100V n’étaient en outre pas considérés comme présentant un risque majeur d’électrocution pour les utilisateurs.

Le système de distribution était de type monophasé 3 fils (3-wire, single-phase, mid-point neutral system) à +110V, 0V et -110V, devant ainsi permettre de réduire la quantité de cuivre utilisée à intensité constante. Cependant, cela ne répondait pas à la question de fond. En effet, ce système revenait à répartir l’intensité entre le + et le -, chaque fil ayant une tension absolue de 110V. Avec un seul fil transportant le courant et de tension 220V, la perte est de P = RI² (car P = UI et U = RI), P étant la puissance (donc multipliée par une durée pour obtenir le nombre de joules dissipées), U la tension, I l’intensité et R la résistance du fil. Avec deux fils, la perte est de P = R_2*(I/2)²+R_2*(I/2)² = R_2*I/2. Si R_2 = R_1, on a bien R_2*I²/2 < R_1*I², mais on utilise deux fois plus de cuivre !

Pour diviser au moins par deux la quantité de cuivre utilisée (le câble peut être assimilé à un cylindre), à longueur constante, il faut diviser le diamètre des câbles au moins par la racine carrée de 2.

Or, la résistance d’un fil est inversement proportionnelle à l’aire de sa section, c’est à dire au carré de son diamètre (si le fil a une section circulaire). Par conséquent, à longueur constante, si l’on divise le diamètre de chaque câble par la racine carrée de 2, on multiplie par 2 sa résistance et ayant ainsi R_2 = 2*R_1, on a finalement R_2*I²/2 = R_1*I², c’est-à-dire aucun gain par rapport à un système monophasé 2 fils.

Toujours est-il que les lampes pouvaient fonctionner entre soit +110 soit -110V et le conducteur neutre à 0V, ce dernier ne servant qu’à transporter la différence de courant entre les sources + et – (unbalanced current).

Malgré cette supposée innovation d’un système monophasé 3 fils (dont je ne vois pas l’intérêt), la perte de tension liée à la résistance des fils de cuivre était si haute que les générateurs ne pouvaient être à plus d’1 mile de la charge. Et des voltages plus importants ne pouvaient pas être si facilement utilisés avec le système de courant continu (DC), défendu par Edison durant la Guerre des courants, car il n’existait tout simplement pas de technologie efficace et à prix raisonnable permettant de réduire significativement la tension (transformateur).

Suite à la victoire in extremis de Westinghouse et Nicola Tesla (voir ici les détails de cet épisode épique de l’histoire de l’électricité), instituant le règne du courant alternatif (AC), le paysage électrique américain changea significativement. Un des principaux avantages du courant alternatif était de pouvoir facilement transformer un très haut voltage en un bas voltage, et donc de permettre le transport de l’électricité sur des grandes distances à très haut voltage (jusqu’à 765kV sur certaines lignes) avec des pertes bien moindres (divisées par le carré de l’augmentation du voltage, à courant constant, d’après la loi d’Ohm U=RI²). Mais malgré la préconisation de Tesla d’utiliser un voltage de 240V (suite à des recherches théoriques), presque suivie (220V) par la plupart des pays d’Europe (qui en étaient encore aux balbutiements de l’électricité et ne faisaient donc pas face à un coût rhédibitoire), aux Etats-Unis il était déjà trop tard pour changer la tension domestique de 120V (au total 240V) mise en place par Edison et pour laquelle tous les équipements ménagers avaient été conçus.

On notera toutefois que Westinghouse suivit la recommandation de Tesla concernant la fréquence utilisée (60 Hz, c’est à dire 60 changements de sens du courant par seconde), qui avait été auparavant méprisée par Edison pour lequel Tesla travaillait. Malgré ses 220V (étant aujourd’hui devenus 230V pour réduire encore les pertes et dans un souci d’harmonisation européen), l’Europe et bien d’autres pays n’ont hélas pas adopté cette fréquence, une juste revanche pour les Etats-Unis, vu les conséquences significatives de ce mauvais choix.

When the German company AEG built the first European generating facility, its engineers decided to fix the frequency at 50 Hz, because the number 60 didn’t fit the metric standard unit sequence (1, 2, 5). At that time, AEG had a virtual monopoly and their standard spread to the rest of the continent. In Britain, differing frequencies proliferated, and only after World War II the 50-cycle standard was established. A mistake, however.

Not only is 50 Hz 20% less effective in generation, it is 10-15% less efficient in transmission, it requires up to 30% larger windings and magnetic core materials in transformer construction. Electric motors are much less efficient at the lower frequency, and must also be made more robust to handle the electrical losses and the extra heat generated. Today, only a handful of countries (Antigua, Guyana, Peru, the Philippines, South Korea and the Leeward Islands) follow Tesla’s advice and use the 60 Hz frequency together with a voltage of 220-240 V. Source

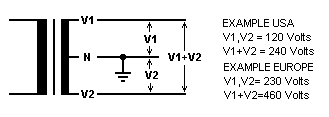

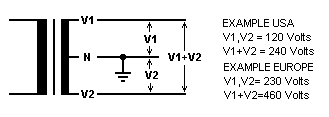

Cela étant, les Etats-Unis peuvent tout à fait obtenir du 240V de leurs prises électriques. La plupart des climatisations, frigidaires, et autres appareils grands consommateurs d’électricité sont ainsi reliés aux deux fils de 120V et -120V (soit 240V de différentiel), plutôt qu’à l’un des deux et au neutre. Les appareils peu gourmands quant à eux se satisfont d’une tension de 120V (source). La plupart des appareils européens nécessitant un transformateur AC/DC (ordinateurs portables, lampes halogènes…), puisqu’ils ont de toutes façons un boîtier dédié à la transformation du courant, acceptent généralement le 120V et le 50Hz. Mais ce ne serait probablement pas le cas d’une machine à laver.

Quant aux prises américaines délivrant une tension de 240V, il n’est pas conseillé de brancher des équipements européens dessus car le système de 240V aux Etats-Unis est réparti sur 2 fils de tension opposée contre 1 seul de 230V en Europe (source, une justification théorique serait cependant bienvenue). Attention, malgré cette séparation en deux fils autour du neutre pour le système américain, il reste cependant bien monophasé (2 fils n’impliquent pas du diphasé). D’ailleurs, en Europe la tension maximum disponible est en réalité de 400-460V (230V sur chaque fil) ! Pour l’exploiter (par exemple dans le cas d’une pompe à chaleur), il est généralement nécessaire de passer en triphasé, c’est à dire demander un raccord à l’opérateur d’électricité sur 3 phases et adapter son système électrique domestique en conséquence. Un dispositif vorace pourra ainsi être branché sur 2 phases (différentiel de 400-460V) plutôt que sur une seule et le neutre (différentiel de 230V) (Source).

3-wire monophase system in the USA and in Europe

Dans quelles prises électriques est-il le plus conseillé d’insérer ses doigts ?

Ayant donc constitué une réponse satisfaisante à ma question initiale, et appris de nombreuses choses au passage sur les générateurs et autres sujets liés de près ou de loin (Tyrannie des liens hypertextes), je me devais alors de répondre définitivement à un nouveau problème pour lequel je fus surpris par la pléthore d’informations souvent spéculatives, incomplètes ou erronées : le 120V est-il moins dangereux que le 230V ?

Vous comprendrez qu’un « oui » ou un « non » ne sont pas de nature à combler ma curiosité, pas plus que le fait d’insérer mes doigts dans la prise de courant mexicaine 120V à 40 cm de mon clavier d’ordinateur (mes doigts sont trop gros de toute façon).

Dans mon infinie miséricorde, je vais vous épargner tous les arguments spécieux en faveur du 120V, et vous exposer mes conclusions, que j’espère n’être ni spéculatives, ni incomplètes, ni erronnées. Peut-être sauverai-je ainsi des vies ;-).

Encore une fois, nous partirons de la loi d’Ohm. Nous savons que lorsqu’un humain relié à la terre touche un conducteur électrique de tension U, la tension traversant son corps est précisément de U. En revanche, le courant le traversant n’est pas nécessairement égal à l’intensité I du conducteur. Comme pour n’importe quel appareil électrique, le courant « tiré » (drawn) du circuit est dérivé de U = RI, où R est la résistance des appareils électriques jalonnant ce circuit. On a I = U/R. Ce qui est sûr ici, c’est que le courant « tiré » ne peut être supérieur à I.

Si la fréquence d’inversion du sens du courant alternatif (50 Hz en Europe, 60 Hz en Amérique du Nord et dans quelques autres pays) est particulièrement néfaste du fait de son entrée en résonance avec le système nerveux, les effets ne varient pas significativement pour 10 Hz de différence (même si 60 Hz est considéré comme plus dangereux). On notera simplement qu’avec un tel courant alternatif, la fibrillation cardiaque peut advenir avec un courant aussi faible que 60 mA, contre 300 à 500 mA pour le courant continu (source). C’était l’un des arguments mis en avant par Edison lors de la Guerre des Courants, allant jusqu’à électrocuter des animaux sur la place publique pour prouver la dangerosité de l’AC, et rebaptiser le terme « électrocuté » en « westinghoused ».

Grâce à la relation I = U/R, et sachant que les dommages subis par un organisme électrocuté augmentent avec l’ampérage le traversant, il ne nous manque plus que R (résistance du corps, fixe) pour calculer I en fonction des différents voltages. Selon des sources concordantes, celle-ci varie entre 1 000 Ohms (peau humide), 10 000 Ohms (peau sèche) et même jusqu’à 100 000 Ohms (peau très sèche).

On obtient ainsi le tableau suivant :

|

Tension

|

Intensité de courant traversant le corps

|

|

I si R = 1 000

|

R = 10 000

|

R = 100 000

|

|

120V

|

120 mA

|

12 mA

|

1,2 mA

|

|

230V

|

230 mA

|

23 mA

|

2,3 mA

|

On remarque immédiatement que l’intensité I disponible a en réalité peu d’importance pour évaluer le danger des prises électriques. En effet, même si l’intensité délivrée par le 230V est environ deux fois inférieure à celle délivrée par du 120V, l’ordre de grandeur est toujours l’ampère (A) voire la dizaine d’ampères, ce qui équivaut quasiment à un courant infini disponible pour s’électrocuter (il suffit de quelques dizaines de milliampères pour subir une électrocution létale, ce qui est bien en-dessous du courant disponible, aussi bien avec le système 120V que 230V). Au mieux peut-on peut-être penser qu’avec du 230V, l’ampérage disponible (10A pour une installation domestique standard) serait insuffisant pour tuer un pachyderme à la peau épaisse. Pour l’homme, ce n’est donc pas parce que la division par deux de la tension sur le réseau est compensée par le doublement de l’ampérage disponible que la quantité d’énergie absorbée en cas de choc est identique. On évince là une des assertions spécieuses avancées par de nombreuses bonnes volontés.

Ainsi, pour un ampérage disponible sur le réseau dans les deux cas bien supérieur au courant létal, le 230V est dans l’absolu deux fois plus dangereux que le 120V. Dans la pratique, il convient bien sûr d’apprécier l’effet de seuil (Source) :

|

Courant électrique (mA)

|

Effet physiologique

|

|

1 mA

|

Seuil à partir duquel un choc est ressenti, douleur

|

|

5 mA

|

Seuil maximum de courant non dangereux

|

|

10-20 mA

|

Contraction musculaire soutenue. Impossible de lâcher le câble par exemple.

|

|

50 mA

|

Interférences ventriculaires, difficultés respiratoires

|

|

100 300 mA

|

Fibrillation ventriculaire. Létal.

|

|

6000 mA

|

Contraction ventriculaire soutenue suivie d’un rythme cardiaque normal.

Ce sont les paramètres d’un défibrillateur cardiaque. Paralysie respiratoire temporaire et brûlures internes possibles

|

On peut donc en conclure que si globalement le 120V limite les risques d’électrocution mortelle (dans le cas d’une peau suffisamment sèche), cela ne reste probablement qu’un effet positif statistique, et ne saurait encourager les utilisateurs à moins de prudence avec du 120V qu’avec du 230V. D’autant que les dommages physiologiques dépendent en grande partie de la durée de contact avec le conducteur ! Si votre main, même relativement sèche, enserre un câble américain pendant 10 secondes, vous aurez très certainement la chance de pouvoir vous plaindre directement auprès de M. Edison !

1 commentaire

1 commentaire